KI-Infrastruktur

17.07.2023, 08:32 Uhr

KI und ML: Cloud oder On-Premises?

Bei Cloud-Services für KI und Machine Learning müssen Kosten und Governance in Einklang gebracht werden.

Cloud und KI sind ein Dreamteam mit besonderen Herausforderungen.

(Quelle: Shutterstock/ArtemisDiana)

Das Leben könnte so einfach sein, auch für Journalisten: «Lieber virtueller Assistent, kontaktiere deine Freunde ChatGPT und Bard und lasse sie einen Artikel zu KI-Plattformen schreiben, die als Cloud-Service verfügbar sind. Und bitte eine passende Anbieterübersicht mitliefern.» Doch das klappt in der Praxis noch nicht, trotz des Hypes, der um generative KI-Formen (generative KI) wie ChatGPT von OpenAI und Bard von Google entstanden ist – mit Betonung auf «noch nicht».

Es ist unumstritten, dass die künstliche Intelligenz und das Machine Learning (ML) bereits heute eine Schlüsselrolle in vielen Bereichen spielen, und diese Entwicklung wird sich beschleunigen – auch in der Schweiz: «Nach unseren Erfahrungen haben Unternehmen und Organisationen die Bedeutung von KI erkannt und investieren in diese Technologie», berichtet etwa Markus Hacker, Director Enterprise Business DACH bei Nvidia. «Es besteht in einer Reihe von Branchen ein starkes Interesse an der Nutzung von KI zur Verbesserung von Effizienz, Produktivität und Innovation.»

Dies gilt nicht nur für die Fertigung, etwa im Automobil- und Maschinenbau und der pharmazeutischen und chemischen Industrie. Auch der Einzelhandel und Dienstleistungssparten wie der Finanzsektor können von KI und Machine Learning profitieren.

KI ist im Alltag angekommen

Nicht vergessen werden sollte, dass künstliche Intelligenz und Maschinelles Lernen (ML) für etliche Unternehmen und Nutzer kein Neuland sind. So hat beispielsweise Microsoft generative KI-Funktionen in seinen Browser Edge integriert und Microsoft 365 um künstliche Intelligenz erweitert: «Wir bieten mit dem in Microsoft 365 integrierten Copiloten die Möglichkeit, KI ohne Programmierkenntnisse in den Arbeitsalltag einzubinden», erläutert Gilbert Jacqué, Azure Solutions Go-To-Market Lead bei Microsoft Deutschland. Ein Beispiel: «Microsoft Teams Premium wird in Kürze den Teilnehmern einer Besprechung direkt nach dem Meeting ein Protokoll und eine Aufgabenliste zur Verfügung stellen können», so Jacqué.

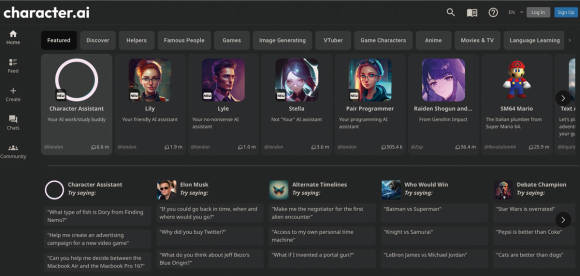

KI-basierte Chatbot-Anwendungen wie Character.AI erstellen künstliche Persönlichkeiten, die sich mit menschlichen Usern austauschen können.

Quelle: Character.AI

Zu den Bereichen, in denen KI-Lösungen in verstärktem Mass anzutreffen sind, zählen vor allem die Kundenbetreuung, inklusive des IT-Supports. Dort kommt Conversational AI zum Zug in Form von Suchmaschinen und Chatbots. «Benutzer können Fragen stellen und erhalten Antworten wie in einem Dialog mit einer Person», erklärt Florian Maximilian Lauck-Wunderlich, Senior Project Delivery Leader bei Pegasystems, einem Anbieter von Low-Code-Plattformen mit KI-Unterstützung. «Der nächste Schritt ist die Implementierung von emotionaler Intelligenz in Chatbots», so Lauck-Wunderlich. Eine KI-gestützte Analytics-Software wiederum kann in Echtzeit auf Basis von Muster-Erkennung und Korrelationsanalysen die Ursachen von Umsatzrückgängen oder den Erfolg von Marketingkampagnen ermitteln.

Cloud oder On-Premises

Generative AI-Lösungen wie ChatGPT von OpenAI, Google Bard, Luminous des deutschen Start-ups Aleph Alpha und Character.AI vom gleichnamigen Anbieter werden das Einsatzspektrum künstlicher Intelligenz deutlich erweitern. Für viele Unternehmen und Organisationen stellt sich daher die Frage, wie und wo sie entsprechende Anwendungen entwickeln und implementieren können: im eigenen Haus beziehungsweise Data Center oder mithilfe von Public-Cloud-Services. Dabei spielen Faktoren eine Rolle wie:

- das vorhandene Know-how in Unternehmen in den Bereichen KI, Machine Learning und Data Science;

- der finanzielle und organisatorische Aufwand, der mit dem Aufbau und Betrieb von KI-Entwicklungskapazitäten und einer IT-Infrastruktur im eigenen Haus verbunden ist;

- dies im Vergleich zu den Kosten, die bei Cloud-Services anfallen, insbesondere vor dem Hintergrund der Preissteigerungen bei Cloud-Angeboten in jüngster Zeit;

- eventuell technische Fragen, etwa Datenleitungen mit hoher Kapazität, die für den Transfer von komplexen KI-Modellen und grossen Volumina von Trainingsdaten in eine Cloud erforderlich sind. Speziell in Deutschland sind Highspeed-Verbindungen in etlichen Regionen immer noch Mangelware;

- der Schutz von geistigem Eigentum, wenn Daten und KI-/ML-Modelle in einer Public Cloud vorgehalten werden;

- Vorgaben durch den Gesetzgeber, etwa im Rahmen der EU-Datenschutz-Grundverordnung und der geplanten Regelungen der EU für KI (Artificial Intelligence Act). Der EU AI Act soll noch 2023 in Kraft treten.

Cloud als «Demokratisierung von KI»

Keine Überraschung ist, dass für Gilbert Jacqué von Microsoft KI aus der Cloud die perfekte Lösung ist:

- Vortrainierte Dienste wie der Azure OpenAI Service stehen Unternehmen jeder Grösse und aus allen Branchen über die Cloud zur Verfügung. Dies ermöglicht im Grunde eine Demokratisierung von KI.» Wer dagegen einen On-Premises-Ansatz wähle, entkopple laut Jacqué seinen KI-Ansatz von weltweit zugänglichen Ressourcen und Tools, die häufig als Open Source verfügbar seien. «Das führt zu strategischen Wettbewerbsnachteilen.»

Auch klassische Vorteile von Public-Cloud-Services kommen bei KI und Machine Learning zum Tragen, etwa die Skalierbarkeit und der Zugang zu speziellen Ressourcen wie Grafikprozessoren (GPUs) und den hohen Rechen- und Speicherkapazitäten, die das Erstellen und Testen von KI- und ML-Modellen erfordert. «Cloud-Nutzer profitieren von einer höheren Effizienz, weil sie die zugrunde liegende Server-Infrastruktur nicht selbst managen müssen», betont Mark Neufurth, Lead Strategist beim deutschen Cloud-Serviceprovider Ionos.

Plattformen wie Google Vertex AI stellen über die Cloud alle erforderlichen Tools zur Verfügung, mit denen Unternehmen KI- und Machine-Learning-Anwendungen entwickeln, trainieren und implementieren können.

Quelle: Google

Wichtig ist aus seiner Sicht jedoch, dass Nutzern die erforderlichen KI- und ML-Tools zur Verfügung stehen, die sie über Application Programming Interfaces (APIs) anbinden und zu einem kompletten AI/ML-Stack erweitern können. Dies erfordert beispielsweise die Unterstützung von ETL- und ELT-Pipelines (Export – Transform – Load und Export – Load – Transform). Speziell der «Transform»-Part ist bei KI und ML wichtig, um Variablen in standardisierte Bereiche umzuwandeln.

“Ein Vorteil von Cloud-basierten KI-Diensten ist, dass sie dazu beitragen können, den ‹Skill Gap› in der KI-Branche zu schliessen.„

Markus Hacker

Director Enterprise Business DACH bei Nvidia

Director Enterprise Business DACH bei Nvidia