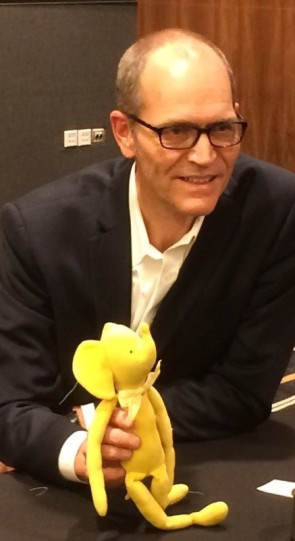

10 Jahre Hadoop - Doug Cutting

15.04.2016, 17:22 Uhr

"Der Riesenerfolg hat mich total überrascht"

Hadoop-Gründer Doug Cutting ist begeisterter Open-Source-Jünger. Mit dem Riesenerfolg seines Babys hat er nicht gerechnet. Die Erfolgsgeschichte von Hadoop im Interview.

Doug Cutting ist der Vater von Hadoop, dem bevorzugten Big-Data-Framework, das heute von Unternehmen wie Facebook, dem CERN und vielen Grossunternehmen für die schnelle Analyse semi-/unstrukturierter Daten eingesetzt wird. Danach sah es anfangs gar nicht aus. Cunning sprach mit Computerworld darüber, wie er vor zehn Jahren eigentlich auf die Idee kam, ein Big-Data-Analysetool zu entwickeln. Ausserdem verriet er uns, welche Hadoop-Distribution die Beste für ihn ist.

Herr Cutting, ihr Baby Hadoop hat kürzlich seinen 10-jährigen Geburtstag gefeiert. Haben Sie mit einem solchen Riesenerfolg gerechnet?

Doug Cutting: Nein, das habe ich ganz sicher nicht und es hat mich total überrascht. Hadoop war und ist ein Open-Source-Projekt, und ich habe natürlich schon gehofft, dass es erfolgreich wird. Der Grund: Ich habe instinktiv gefühlt, dass diese Technologie für sehr viele Menschen eine grosse Hilfe sein würde. Aber ich habe dabei an Leute gedacht, die sich mit der optimierten Suche im Web oder mit Spracherkennung beschäftigen, wie ich auch zu dieser Zeit. Dass dann die ganzen professionellen Typen aus der traditionellen Finanzindustrie, der Versicherungsbranche, dem Gesundheitswesen und Einzelhandel einsteigen, hätte ich nie im Leben gedacht. Das war dann doch eine sehr grosse Überraschung.

Wie sind Sie überhaupt auf die Idee gekommen, eine Big-Data-Analyseplattform wie Hadoop zu entwickeln? Bitte erzählen Sie uns die ganze Geschichte.

Cutting: Die ganze Geschichte, da würden wir morgen noch hier sitzen. Ich wollte eine Software entwickeln, die Menschen benutzen und die ihnen weiterhilft. Gleichzeitig ging es mir darum, genug Geld zu verdienen, um mit meiner Familie davon leben zu können.

Ich hatte damals Lucene auf die Beine gestellt, eine Open-Source-Bibliothek für die Informationsrecherche. Lucene hatte sich sehr schnell zum Industriestandard entwickelt. Viel schneller, als das mit einer herkömmlichen kommerziellen Lizenz-Software funktioniert hätte. Und mit der Zeit hatte sich eine Open-Source-Gemeinde um Lucene zusammengefunden, die das Produkt wesentlich verbessert hat. Das war eine sehr gute Erfahrung, die mich für Open-Source begeistert hat, und bei Open-Source bin ich seitdem geblieben.

Nach Lucene habe ich begonnen, an Nutch zu arbeiten. Nutch ist ein Open-Source-Tool für die Websuche, für das wir eine skalierbare Lösung brauchten, die mit verteilten Computing zurechtkommt. Die Arbeitslast wird also auf viele Rechnerknoten verteilt und parallel abgearbeitet, was die Performance extrem erhöht. Google höchstpersönlich hat dann Software für verteiltes Computing veröffentlicht, die viel besser war als das, was wir in Nutch benutzt haben. Es lag also nahe, Googles Open-Source-Routinen in Nutch einzubauen. Diese Routinen sind der Software-Kern des späteren Hadoop.

Es gibt heute eine Handvoll Hadoop-Releases auf dem Markt, die mit Verbesserungen wie SQL und einer leichteren Bedienung glänzen: Cloudera, Hortonworks, IBM, MapR und Pivotal. Das Original-Hadoop ist ja doch recht sperrig zu bedienen. Welches Release finden Sie am Besten?

Cutting: Cloudera ist am schnellsten, am leichtesten zu benutzen und ist auch sicherer als die anderen Distributionen. Aber ich möchte jetzt kein Verkaufsgespräch veranstalten. Ich empfehle jedem, sorgfältig die Releases zu evaluieren und dann den Vendor auszuwählen, der seine Wünschen am Besten erfüllt. Konkurrenz spornt uns alle dazu an, unsere Lösungen weiter zu verbessern.

Was sind typische Use Cases für Hadoop? Ist es auch für das Internet der Dinge geeignet?

Cutting: In Hadoops Ökosystem laufen Projekte, die riesige Echtzeit-Applikationen zum Thema haben. Facebook und das CERN in Genf machen intensiven Gebrauch von Hadoop. Facebook zum Beispiel nutzt HBase, die Datenbank von Hadoop, für seinen sehr performanten Messaging-Dienst. Cloudera hat mehrere Kunden, die "Spark Streaming" für Analysen in Echtzeit einsetzen. Ausrüster und Maschinenbauer setzen Hadoop ein, um potentielle Ausfälle von Maschinenteilen vorauszusagen und ihre Wartungszyklen damit zu optimieren.

Wie sehen Sie die Zukunft von Hadoop? Welche Erweiterungen sind geplant?

Cutting: Hadoop sehe ich als Kernkomponenten von IT-Plattformen der nächsten Generation. Es ist kostengünstig und skaliert viel besser als andere Lösungen. Im Werkzeugkasten von Hadoop steckt mittlerweile nicht nur SQL, sondern auch Komponenten wie Machine Learning, Suchfunktionen oder "Stream-Processing". Hadoop unterstützt iterativ ganz unterschiedliche Typen von Daten. Und durch seine Open-Source-Wurzeln kann sich Hadoop sehr schnell weiterentwickeln und auf Kundenwünsche reagieren.