Firmenfachbeitrag

07.01.2019, 09:00 Uhr

07.01.2019, 09:00 Uhr

Keine Abkühlung beim maschinellen Lernen

Zwischen etwa 1990 und 2005 kühlte sich die Euphorie für Artificial Intelligence so weit ab, dass die bis dahin äusserst vielversprechende Industrie nahezu komplett zusammenbrach. In Anlehnung an den «nuklearen Winter» wird diese Phase als «AI-Winter» bezeichnet. Heute boomt die künstliche Intelligenz, bzw. deren wichtigster Zweig das maschinelle Lernen, wieder – mehr als jedes andere Gebiet in der IT. Eine nochmalige Abkühlung der Nachfrage ist aber nicht mehr zu erwarten.

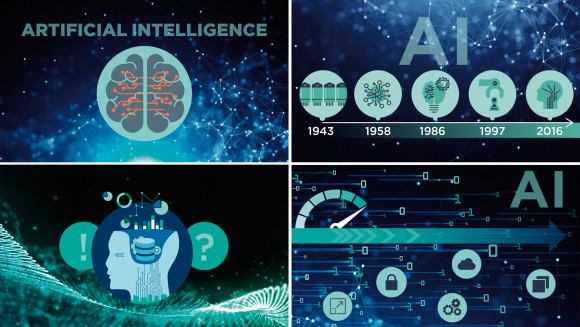

Versuche, das menschliche Gehirn nachzuahmen, haben eine lange und bewegte Geschichte

(Quelle: NetApp)

Der Begriff künstliche Intelligenz (KI) oder Artificial Intelligence (AI) bezeichnet den Versuch, Computer so zu programmieren, dass sie eigenständig Probleme bearbeiten und menschenähnliche Entscheidungen treffen können. Die «Intelligenz» der Maschine entsteht – wie beim Menschen – durch Lernen. KI im engeren Sinne (auch «starke KI») zielt darauf ab, eine Maschine zu entwickeln, die sich wie ein Mensch verhält, also auch intelligent wie ein Mensch reagiert. Dies ist auch nach jahrzehntelanger Forschung nicht ansatzweise gelungen und gilt heute als eine akademische Vision ausser Reichweite. Im Gegensatz dazu befasst sich die sogenannte «schwache KI» mit maschinellem Lernen (Machine Learning oder ML). Dabei wird ein System mit zahlreichen Daten gefüttert und lernt, über die Beispiele hinaus selbstständig Muster und Gesetzmässigkeiten zu erkennen. Herzstück der Systeme des maschinellen Lernens sind künstliche neuronale Netze. Dabei handelt es sich um eine mathematische Abstraktion, also ein Modell der Informationsverarbeitung, wie sie in ähnlicher Weise im Gehirn stattfindet. Ein Neuron wird als Funktion (Algorithmus) modelliert, einschliesslich Input, Parametern und Output. Beim Lernen werden die Parameter verändert. Das Modell lernt durch Modifikation der Gewichtung, was wichtig ist und was nicht und liefert so zunehmend bessere Resultate.

Auf dem erstem Boom folgte der AI-Winter

Die ersten ganz einfachen neuronalen Netze der 1970er Jahre, die Bilderkennung ermöglichten, hatten Eigenschaften, die denen des Gehirns entsprachen und auf den ersten Blick wie Magie wirkten. Es entstand die Erwartung, dass sich die künstliche Intelligenz zu einer Schlüsseltechnologie entwickeln würde und dass Computersysteme schon bald repetitive Aufgaben aus der Arbeitswelt übernehmen könnten. KI würde zur Entlastung der Arbeitnehmer, zu schnelleren und besseren Ergebnissen und zu Kosteneinsparungen führen. Doch die Fortschritte in der Entwicklung künstlich intelligenter Softwaresysteme blieben hinter diesen Erwartungen zurück. Zum einen hatten die Speichersysteme nicht die erforderlichen Kapazitäten und I/O-Performance, sodass die grossen Datenmengen zum Trainieren der Systeme fehlten, zum andern waren die Computer nicht schnell genug für die aufwendigen Berechnungen. Den Entwicklern unterlief wohl auch der eine oder andere Fehler. Weil sich nicht absehen liess, wie die Modelle jemals sinnvoll und profitabel eingesetzt werden könnten, verloren ab etwa 1990 sowohl die Verantwortlichen bei den staatlichen Forschungsförderungsorganisationen wie auch Risikokapitalgeldgeber ihr Interesse an der künstlichen Intelligenz bzw. dem maschinellen Lernen. Die vielversprechende Industrie brach zusammen. In Anlehnung an den «nuklearen Winter» wird diese Phase als «AI-Winter» bezeichnet.

Mit RNN erlernen Maschinen das zuvor unerlernbare

Eine Arbeitsgruppe des deutschen Informatikers Jürgen Schmidhuber entwickelte 1991 eine Methode, um bis dahin nicht lernbare Aufgaben für Maschinen erlernbar zu machen: die sogenannten rückgekoppelten neuronalen Netze (Recurrent Neural Networks, kurz RNN). Die in Schichten angeordneten Modellneuronen sind dabei nicht nur innerhalb einer Schicht miteinander verbunden, sondern auch von Schicht zu Schicht. Im Gehirn ist dies die bevorzugte Verknüpfung neuronaler Netze, insbesondere im Neocortex. Diese Verschaltungsweise ermöglicht es, in den Daten zeitlich codierte Informationen zu entdecken. Zur Anwendung kommen rekurrente neuronale Netze beim Verarbeiten von Sequenzen, zum Beispiel in der Spracherkennung, der Handschrifterkennung und der maschinellen Übersetzung. Dank RNN erkennen die Systeme nicht nur einzelne Wörter, sondern auch deren Kontext. In Abhängigkeit von dem, was vorhergesagt wurde, versucht der Computer herauszufi nden, was als Nächstes gesagt werden könnte.

Jürgen Schmidhuber verbesserte das System 1997 zusammen mit dem deutschen Informatiker Sepp Hochreiter noch weiter, indem er die Technik «long short-term memory» (LSTM) entwickelte. Das «lange Kurzzeitgedächtnis» verleiht dem maschinellen Lernen eine Art Erinnerung an frühere Erfahrungen: ein Kurzzeitgedächtnis, das lange anhält. Schmidhuber bezeichnet seine Recurrent Neural Networks mit LSTM als Deep-Learning-Netzwerke. Diese Technik, das Deep Learning (DL), feiert seit 2016 bedeutende Erfolge und ist für den aktuellen Boom der künstlichen Intelligenz verantwortlich. Inzwischen ist eine perfekte Balance entstanden – immer komplexere Probleme lassen sich mit immer komplexeren Modellen gerade noch lösen. Das weckt neue Bedürfnisse – und ermöglicht Investitionen in schnellere Hardware.

Plattform für maschinelles Lernen

Im maschinellen Lernen stehen heute grossartige Computer zur Verfügung, allen voran Nvidias DGX – die Einschränkung lag jedoch bis vor kurzem beim Lesen und Schreiben der Daten (I/O) von den Speichermedien. Mit der Einführung der Massenspeicherschnittstelle NVMe und 100 Gigabit Ethernet ab 2017/2018 konnte schliesslich auch diese Hürde beseitigt werden. Die Ansprüche an Netzwerke, I/O-Bandbreite, I/O-Geschwindigkeiten und Data-Feeds sind enorm. Daher war es nur konsequent, dass Nvidia und der US-amerikanische Datenmanagementspezialist NetApp am 1. August 2018 die Kombination eines DGX-Supercomputers mit dem schnellsten All-Flash-Speichersystem, NetApps AFF A800, als konvergente Infrastruktur vorstellten. Durch die Kombination von NVMe-SSDs (Solid-State Drives) und der ersten NVMe-over-Fibre-Channel-Konnektivität (NVMe/FC) erreicht die All-Flash FAS A800 in einem 24-Node-Cluster eine Latenz von weniger als 200 Mikrosekunden und einen überaus hohen Durchsatz von bis zu 300 GB/s. Die DGX-1 von Nvidia liefert im Vergleich zu einem üblichen Prozessor mit 3 teraFLOPS die 56fache Leistung und rechnete ein DL-Modell, dessen Kalkulation 6,25 Tage benötigte, 75-mal schneller. Diese Architektur vereinfacht und beschleunigt den Weg von Daten zwischen dem Entstehungsort, dem Rechenzentrum und der Cloud und macht diese Pipeline skalierbar.

Diese Lösung ermöglicht den schnellen Einstieg in das KI-Umfeld, indem sie die Komplexität des Lösungsdesigns eliminiert. Mit zunehmendem Wachstum der Datenmenge kann sie von einer 1:1-Konfiguration nach oben unbegrenzt skaliert werden. Dank redundanter Speicherung, sowie Netzwerk- und Serveranbindung ist sie hochverfügbar.

NetApps Konzept der Data Fabric ermöglicht es Anwendern von ONTAP AI, eine nahtlose Datenpipeline – vom Entstehungsort bis ins Rechenzentrum oder in die Cloud – zu nutzen. Data Fabric beschreibt das grenzenlose zentrale Management von Daten über alle Ressourcen hinweg – inklusive der Cloud. Innerhalb der Data Fabric können Datenbestände sicher über alle Infrastrukturen transferiert werden, unabhängig davon, wo sie stehen. So kann Rechenleistung wahlweise im eigenen Rechenzentrum oder als Service in der Cloud bezogen werden – NetApp kümmert sich um das Datenmanagement.

Maschinelles Lernen wird also weiterhin boomen. Deep-Learning-Netzwerke, Datenmengen in Grössenordnungen von Zettabytes, die Massenspeicherschnittstelle NVMe, GPU-Supercomputer mit teraFLOPS-Power, sowie cloud-integrierbares All-Flash-Storage bilden die perfekte Plattform für eine sich rasch entfaltenden Industrie mit unzähligen Möglichkeiten.

Zum Autor

Christoph Schnidrig ist Informatiker TS mit einem NDS in Wirtschaft und Manager Systems Engineering bei NetApp Schweiz.

Zum Unternehmen: NetApp ist ein weltweit tätiger Spezialist für das Datenmanagement in hybriden Cloud-Umgebungen.

Mehr Informationen: www.netapp.ch

Dieser Beitrag wurde von der NetApp Switzerland GmbH zur Verfügung gestellt und stellt die Sicht des Unternehmens dar. Computerworld übernimmt für dessen Inhalt keine Verantwortung.