22.06.2009, 09:39 Uhr

Superschnelle Analysen in Echtzeit

In-Memory-Technologie bringt Datenbanken und Data Warehouses auf Touren. Wie funktionieren diese Abfragetechniken und wie schnell sind sie wirklich?

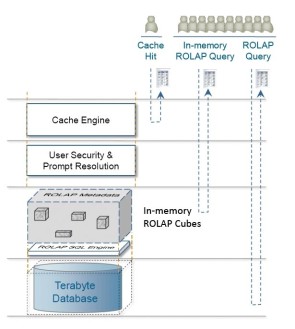

Vergleich: BI-Analysetechniken Die im Cache abgespeicherten Ergebnisse stark nachgefragter Analysen sind am schnellsten zugänglich. Der Plattenzugriff dauert am längsten

SAP-Mitbegründer Hasso Plattner ist begeistert. Für ihn spricht vor allem die rasende Performance für den Einsatz von In-Memory-Techniken: Kombiniert mit Kompressionsalgorithmen, würden dadurch auch sehr komplexe Data-Warehouse-Abfragen bis zu hundertmal schneller. Topmanager müssen nicht mehr Stunden oder Tage auf entscheidungsrelevante Analyse-Ergebnisse warten. «Wenn alle Informationen nahezu in Echtzeit vorliegen, wird das unser Arbeiten umkrempeln und ganz neue Geschäftsmodelle ermöglichen», sagte Plattner kürzlich auf der SAP World Tour in Mannheim. Auch das neue ERP-System SAP Business ByDesign, das voraussichtlich Ende des Jahres auf den Markt kommt, arbeitet mit dieser superschnellen Analysetechnik.

Festplatten auf dem Mars

Was macht In-Memory-Technologie so attraktiv? Ein Vergleich hilft hier weiter: Angenommen, der sehr prozessornahe Level-1-Cache wäre ein Rechenzentrum in Winterthur. Der etwas langsamere Level-2-Cache entspräche der Stadt Winterthur, Daten im Hauptspeicher (in memory) wären über den Kanton Zürich, Daten auf Solid-State-Disks (Flash) über Zentraleuropa verteilt. Auf Festplattenmedien abgespeicherte Informationen, heutzutage oft noch der Normalfall, befänden sich in diesem Beispiel dann buchstäblich auf einem anderen Planeten, nämlich auf dem Mars.

Wer sehr schnell, nahezu in Echtzeit, riesige Datenmengen auswerten will, packt also so viel wie möglich in den Hauptspeicher. Das sei heute auch problemlos möglich, rechnet Plattner vor. Kombiniert man das Memory von 100 Blade-Servern, ergibt sich eine Hauptspeicherkapazität von 50 Terabyte. Das reiche selbst für grosse Data Warehouses aus. Ausserdem könnten im Hauptspeicher befindliche Datenbanken spalten-, das heisst feldweise ausgewertet werden, was weitere Performance-Vorteile bringt. Denn der normale Festplattenzugriff liest Datenbanken satzweise aus und schleppt dadurch auch Datensatzfelder mit, die für die aktuelle Auswertung gar nicht benötigt werden. Im Durchschnitt sind nur 10 Prozent der in einem Datensatz abgespeicherten Infos für Abfragen relevant. Die restlichen 90 Prozent sind nur unnötiger Ballast, der die Analyse zusätzlich ausbremst.

Dynamische OLAP-Würfel

Nicht nur aus Kapazitätsgründen verfolgen Datenbank- und BI-Anbieter zurzeit jedoch eine hybride Strategie. MicroStrategy lädt auf bestimmte Abfrageklassen optimierte ROLAP-Würfel, also auf relationale Datenbanken aufbauende OLAP Cubes (Online Analytical Processing), in den Hauptspeicher. «Der ROLAP-Würfel passt sich dynamisch den Nutzeranfragen an», erklärt Dominik Hertzog, Marketing Director EMEA bei MicroStrategy. Häufig nachgefragte Informationen werden ins schnelle Memory geladen und dort belassen. Interne Messungen ergaben eine Performance-Verbesserung um mehr als 65 Prozent. Durchschnittliche Antwortzeiten von 21,1 Sekunden auf einer optimierten Oracle-Datenbank verkürzten sich durch In-Memory-ROLAP-Cubes auf 9,5 Sekunden. Benötigt ein User einmal Infos, die der Würfel nicht vorhält, ist zwar auch der Direktzugriff aufs Data Warehouse möglich. Aber das befindet sich dann wieder auf dem Mars. Extrawünsche dauern im Hybridmodell eben etwas länger.

«Wir bilden kein komplettes Data Warehouse in memory ab», erläutert auch Jürgen Klein, Director Services beim BI-Anbieter QlikTech. Die entscheidende Frage sei, welche Daten in den Hauptspeicher kommen, wo nach Massgabe der Nutzervorgaben ein virtueller Würfel erstellt wird. Jeder Mausklick hat nach Klein eine neue Berechnung des virtuellen Würfels zur Folge. Das macht virtuelle InfoCubes sehr flexibel.

Für Kleine BI-Anwendungen geeignet

In-Memory-Technologie kann Data Warehouses ersetzen, aber zurzeit nur im Mittelstand mit mittleren Datenvolumina, schätzt Klein. Ähnlich sieht es auch MicroStrategy-Mann Hertzog: «Lösungen mit In-Memory-Technologie eignen sich besonders für kleinere BI-Anwendungen auf Arbeitsgruppenebene.» Anscheinend ist die Technik vom grossen Durchbruch doch noch ein gehöriges Stück weit entfernt. Oder sind die Anbieter einfach noch nicht so weit?

«In-Memory- und Data-Warehouse-Technologie ergänzen sich sinnvoll und werden immer weiter verschmelzen», meint Matthias Krämer, Produkt- und Performance-Manager beim Unternehmenssoftware-Anbieter Infor. Ausgereifte In-Memory-Datenbanken wie Infor PM OLAP speichern den im Hauptspeicher befindlichen Datenbestand asynchron und in zeitlichen Intervallen auf Festplatte ab. Dadurch könne

die gleiche Datensicherheit wie bei Data-Warehouse-Anwendungen erreicht werden.

die gleiche Datensicherheit wie bei Data-Warehouse-Anwendungen erreicht werden.

Einen Blick in die Zukunft wagt André Münger, Director bei Information Builders Schweiz in Dietlikon: «Längerfristig sehen wir In-Memory-Technologie als Teil von Datenbanken wie Oracle, DB2 oder SQL Server, also als Ergänzung klassischer OLAP-Anwendungen.»

Münger warnt allerdings vor übertriebener Euphorie: «Wir haben In-Memory-Systeme gesehen, bei denen das Laden von In-Memory-Datenbanken im BI-Bereich bis zu dreieinhalb Stunden in Anspruch genommen hat.» Das sei so, als ob der Weltrekordhalter Usain Bolt die hundert Meter in 2,3 Sekunden laufe, aber einen Marathon als Anlauf dazu brauche, witzelt Münger.

Kosten: 60- bis 80-mal teurer

Vor einer umfassenden Einführung rät Münger, eine Kosten-Nutzen-Rechnung anzustellen. RAM sei, verglichen mit Plattenspeicherplatz, heute um den Faktor 60 bis 80 teurer. Krämer geht von einem zusätzlichen RAM-Bedarf von deutlich mehr als 20 Prozent pro Arbeitsplatz aus. Information Builders setzt daher In-Memory-Technologien schwerpunktmässig im Bereich der Datenvisualisierung für explorative Analysen ein.

Das technisch Machbare ist nicht immer auch das ökonomisch Sinnvolle. Zusätzlich sprechen Sicherheitsgründe für ein hybrides Modell der Datenhaltung. Fällt nämlich der Strom aus und springt das Notstromaggregat nicht zeitnah in die Bresche, sind sämtliche im Hauptspeicher vorgehaltenen Informationen unwiederbringlich perdu.

Business ByDesign: 3-Layer-Konzept

Die Hasso-Plattner-Company SAP schlägt bei ihrer neuen ERP-Lösung den hybriden Weg ein. Business ByDesign verfolgt ein Datenhaltungskonzept, das aus drei Layern besteht.

Als sichere Persistenzschicht dient eine klassische relationale Datenbank, die alle Daten auf Festplattenmedien speichert. Einfache und aggregierte InfoCubes optimieren bestimmte Abfrageklassen durch Data-Warehouse-Techniken wie Dimensionen. Für rasend schnelle Abfragen quasi in Echtzeit liegen die Daten noch einmal im Hauptspeicher vor. Was das bringt, demonstrierten die Walldorfer live auf der SAP World Tour in Mannheim: Das BI-Werkzeug BusinessObjects Explorer wühlte sich in 15 Millisekunden durch 366 Millionen Datensätze. Die Trefferliste der Abfrage umfasste dabei knapp eine Million Records.

Branchenstärken der BI-Anbieter

Jedoch ist nicht nur die Geschwindigkeit, sondern auch die Qualität der BI-Analysereports entscheidend für den erzielten, geschäftlichen Mehrwert. Daher sollten Anbieter zusätzlich zum technischen Know-how auch über intime Branchenkenntnisse verfügen. BI-Guru Nigel Pendse kommt in seinem «BI Survey 8» zu folgender Einschätzung: MicroStrategy ist überdurchschnittlich gut bei Handel- und Telekommunikations-Lösungen, Information Builders im Versicherungs- und Gesundheitswesen, Oracle BIEE bei IT-Diensten, und QlikView spielt seine Stärken vor allem in der Fertigung und Produktion aus.